机器视觉中,常见的误判原因分析

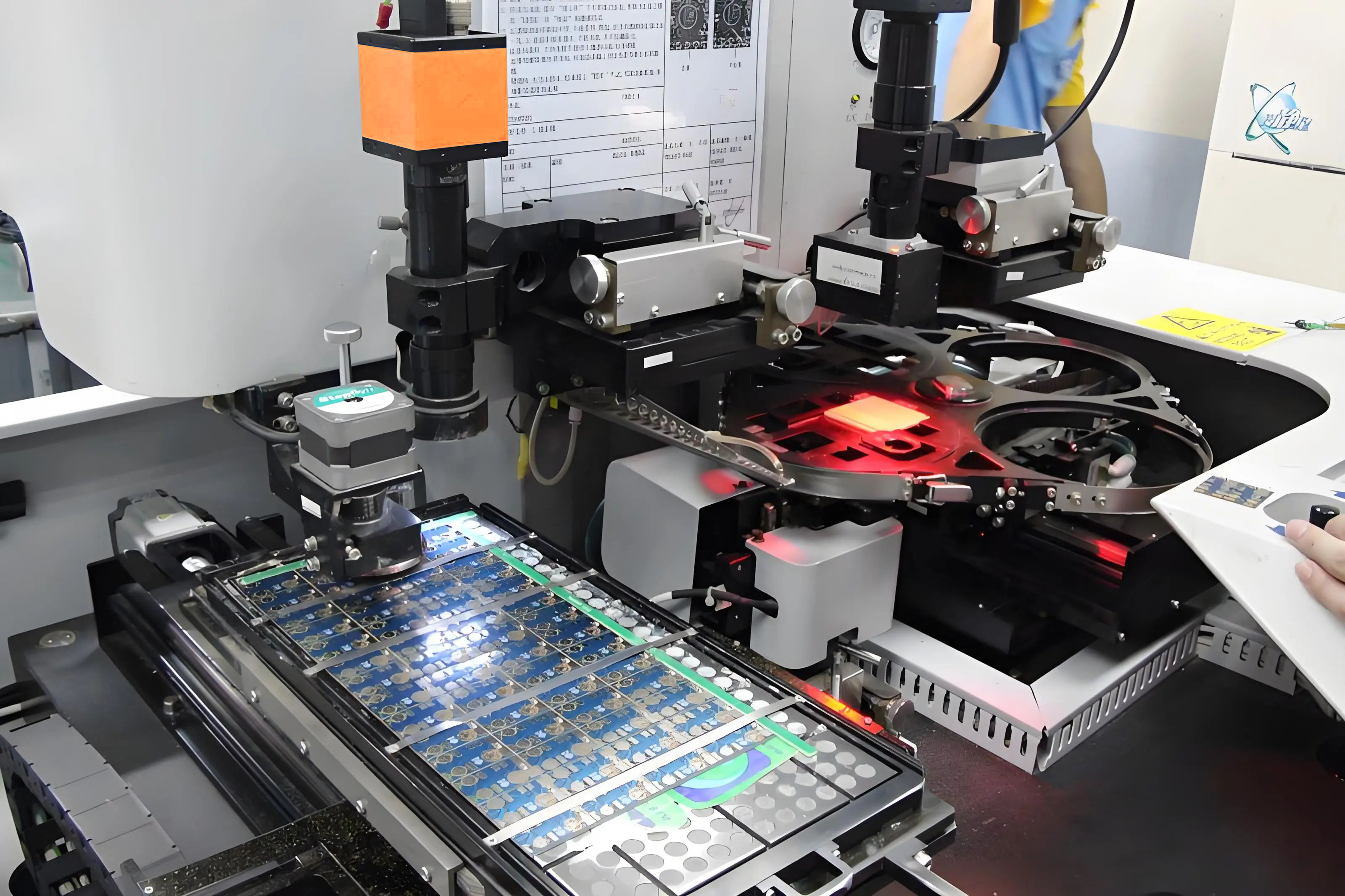

随着工业自动化和智能制造的发展,机器视觉技术成为了重要的检测手段。然而,在实际应用中,机器视觉系统仍然面临着许多误判的问题。这些误判不仅会影响生产效率,还可能导致产品质量不达标,给企业带来严重的经济损失。那么,导致机器视觉系统误判的原因有哪些呢?

机器视觉项目频繁出现误判,本质是“算法对真实世界的理解偏差”与“工程落地中的变量失控” 共同作用的结果。从技术原理到工程实施,每个环节的微小漏洞都可能被放大,最终导致误判。下面我们详细分析:

1. 数据问题 - 训练数据的“偏科”或“不完整”

这是最根本、最常见的原因,可以说80%的误判问题都源于数据。

数据量不足: 少数类样本(如“有缺陷的产品”)数量极少,模型偏向学习“正常样本”的特征,导致对少数类的误判(如把“微小裂纹”误判为“正常”)。

数据标注错误:人工标注时的疏忽(如把“划痕”标为“污渍”)会让模型学习到错误特征,后续遇到同类场景时自然会延续误判。

图像质量差: 图片模糊、过曝、过暗、畸变,就像字迹潦草的考卷,学生都看不清,何谈答题?

数据多样性不够:

场景单一: 真实场景中存在的变量(如光照、角度、物体状态)未被纳入训练数据。例如:检测流水线上的瓶盖缺陷时,只采集了“正面光照”的数据,当生产环境改为“侧面逆光”,瓶盖阴影导致缺陷特征被掩盖,模型就会误判(漏检)。

目标形态单一: 训练数据里的苹果都是红的、完整的,但产线上可能出现青苹果、有疤痕的、被咬了一口的,模型就不认识了。

数据不平衡: 1000张“合格品”图片,只有10张“瑕疵品”图片,模型会倾向于把所有东西都预测为“合格品”,因为这样它的整体正确率最高,但完全漏掉了瑕疵。

2. 模型与算法问题 - “自身能力和学习方法有问题”

2. 模型与算法问题 - “自身能力和学习方法有问题”

算法是机器视觉的“大脑”,但它无法像人类一样具备“常识推理”能力,只能依赖数据和特征学习,这是误判的底层原因。

模型选择不当: 用解决分类问题的模型去做复杂的物体检测任务,就像让小学生去解微积分。

模型欠拟合: 模型太简单,无法学习数据中复杂的特征。模型未能捕捉到“区分正常与异常的核心特征”,反而学习了无关特征。

模型过拟合:模型太复杂,把训练数据中的噪声和无关细节都当成了规律来学习。过度依赖训练数据的细节(如背景中的特定污渍、固定的拍摄角度),当测试场景与训练场景有微小差异(如背景更换、物体位置偏移),模型就会把“正常变化”误判为“异常”。例如:训练时用“白色背景”检测零件,实际生产中背景变为“浅灰色”,模型可能把背景色差异误判为零件表面缺陷。

算法局限性: 某些算法本身在处理遮挡、形变、极端光照等情况时就有理论上的弱点。

3.硬件问题 - 图像采集环节的“信号失真”

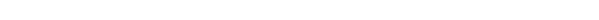

光照变化: 这是工业视觉的“头号杀手”。阳光、灯光、设备反光、阴影的轻微变化,都会彻底改变物体在相机中的成像。

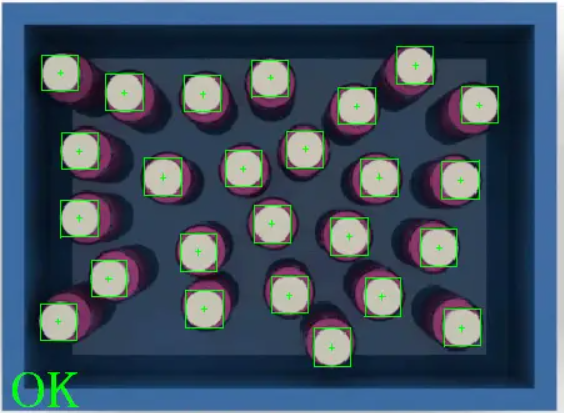

镜头畸变与对焦: 镜头质量差或未校准,导致图像失真或模糊。广角镜头导致边缘物体变形(如圆形零件拍成椭圆形),或对焦偏移让物体细节虚化,模型可能把“变形/虚化”误判为“形状缺陷”。

相机分辨率不足:需要检测的“微小特征”(如0.1mm的划痕)超出相机分辨率极限,图像中该特征模糊成“噪点”,模型无法识别(漏判)。

4.

4.环境变量:真实环境的“不可控干扰”

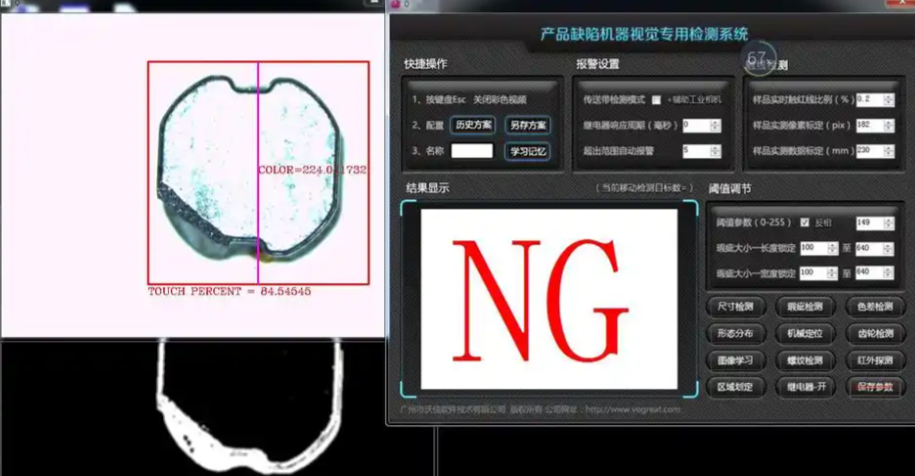

机器视觉项目落地的场景(如工厂流水线、室外道路)存在大量算法未覆盖的干扰因素,这些因素会直接破坏“图像特征的稳定性”。

相机抖动: 安装不稳固或产线振动导致图像模糊。

背景干扰: 产线上突然出现一个无关的物体,或者背景杂乱,干扰了模型的判断。

杂物的干扰:流水线上的粉尘、油污附着在物体表面,或传送带的磨损痕迹,会被模型误判为“物体自身的缺陷”(如把瓶盖表面的粉尘误判为“划痕”)。

5. 部署与集成问题 - 系统集成的“衔接漏洞”

机器视觉不是“算法+相机”的简单组合,而是“硬件、软件、场景流程”的协同系统,任何环节的衔接问题都会导致误判。

领域漂移: 训练数据和实际生产数据分布不一致。比如,训练时用的是A型号相机,部署时换了B型号,色彩风格有差异;或者产品材料、供应商发生了变化。

标定与校准的缺失:

相机标定不足。未对相机进行“畸变校正”或“像素尺寸标定”,导致图像中的“物理尺寸计算错误”。例如:检测零件高度时,因标定偏差,模型把“合格的5mm高度”计算为“5.5mm”,误判为“尺寸超标”。

光源校准缺失:未定期校准光源的亮度、色温,随着使用时间推移,光源参数偏离初始设定,导致图像特征变化,模型沿用旧参数判断,引发误判。

阈值设置不当: 模型输出的是一个概率值(如“有瑕疵的概率是85%”),需要设定一个阈值(如50%)来判断。阈值设得太高,会漏掉一些模糊的瑕疵(漏报);设得太低,则会把很多合格品判为瑕疵(误报)。

触发信号延迟:流水线的“触发相机拍照”信号(如光电传感器信号)延迟,导致相机在物体未完全进入拍摄区域时就拍照,图像中物体不完整,模型无法判断(误判为“物体缺失关键特征”)。

数据传输丢包:相机采集的图像在传输到算法服务器时发生丢包,导致图像部分区域损坏(如出现黑色块),模型可能把“损坏区域”误判为“物体缺陷”。

软件版本与环境不一致: 开发环境和生产环境的软件、驱动、库版本不同,可能导致意想不到的行为。

6、后期维护:缺乏持续的“迭代优化

很多项目认为“上线即结束”,但真实场景是动态变化的(如产线升级、物体型号更换),模型若不持续优化,会逐渐无法适应新场景,误判率上升。

1. 未积累新场景数据

上线后遇到的“新类型缺陷”“新干扰因素”(如突然出现的原材料杂质)未被记录和标注,模型从未学习过这些特征,自然会误判(漏判新缺陷,或把新干扰误判为缺陷)。

2. 模型未定期更新

随着产线参数调整(如流水线速度提升、光源更换),图像特征发生变化,但模型仍使用初始版本,导致判断标准与实际场景脱节,误判率升高。

即使数据、硬件、工程都做到极致,仍会存在“边缘案例”(即极罕见、难以提前覆盖的场景),这些场景会导致误判——这是机器视觉目前无法完全解决的问题。

例如,检测瓶装水时,极偶尔有“气泡恰好附着在瓶口密封处”,且气泡形状与“密封缺陷”高度相似,模型会误判;

总结:如何减少误判?——从“全链路管控”入手

误判不是单一环节的问题,需从“数据→算法→硬件→场景→维护”全链路优化:

1. 数据层:采集更全面的场景变量(光照、角度、干扰),保证数据均衡,定期修正标注错误;

2. 算法层:选择泛化能力强的模型(如基于Transformer的视觉模型),通过“数据增强”模拟极端场景,避免过拟合;

3. 硬件层:根据场景需求选型(如高速场景用全局快门相机),定期标定相机和光源;

4. 工程层:合理设置ROI和动态阈值,确保与产线流程协同(如同步触发信号);

5. 维护层:建立“误判案例库”,定期用新数据更新模型,持续迭代优化。

总结来说,机器视觉的误判是其“天生缺陷”与现实世界复杂性的碰撞。它不是一个“一劳永逸”的项目,而是一个需要持续优化、维护和学习的“生命体”。真实世界的复杂性决定了误判无法完全消除,但通过全链路管控,可将误判率降低到可接受的业务标准(如工业场景通常要求误判率<0.1%)。

致瑞图像深耕智能视觉领域多年,如果您想了解更多,可以点击

致瑞新闻

致瑞新闻